AI烘焙大赛中的算法:理解PPO、GRPO与DPO最简单的方式

🧠 向所有学习者致敬!

“学习不是装满一桶水,而是点燃一把火。” —— 叶芝

我的博客主页: https://lizheng.blog.csdn.net

🌐 欢迎点击加入AI人工智能社区!

🚀 让我们一起努力,共创AI未来! 🚀

## 🧐 作者开场白:当数学公式遇上厨房烟火 "各位看官,是时候给这些高深莫测的算法概念松松土了!我翻遍了arXiv上那些让人头秃的论文,发现它们不是在堆砌数学公式,就是在用更复杂的数学公式解释上一个数学公式。今天,本AI厨神就要用最接地气的烘焙大赛来拆解这些算法,保证让您看得津津有味,连隔壁卖煎饼的王大妈都能听懂!当然啦,硬核读者老爷们也别急着走——文末附上了原论文传送门:PPO、GRPO、DPO。不过先说好,看完那些公式要是头秃了,可别来找我索赔植发费用哦~"

🍰 关键术语翻译局:米其林后厨黑话手册

1. 策略模型 → 烘焙选手

想象一个穿着厨师服、头顶高帽的AI选手,每天都在后厨疯狂烤制500个戚风蛋糕。它的任务就是不断尝试新配方,期待有一天能登上《厨神争霸》的舞台。

2. 模型参数 → 祖传秘方

这可不是普通的菜谱!里面记载着:“面粉要过筛三次”、“蛋白打发要逆时针搅拌”、“烤箱温度要精确到±1℃”——这些细节决定了你的蛋糕是米其林三星还是黑暗料理。

3. 奖励模型 → 毒舌评委

请想象Gordon Ramsay戴着单边眼镜,用银质餐刀轻轻切开蛋糕:“外皮烤焦了0.3毫米!内馅甜度超标!摆盘毫无艺术感!” —— 每个毒舌点评都在逼着AI选手进步。

4. 价值函数 → 预言家厨神

这位白胡子老师傅会摸着水晶球说:“依老夫看,这个选手三年后必成大器!”——他通过观察选手的学习曲线、创新能力和稳定性来预测未来潜力。

5. KL散度约束 → 防翻车警报器

当AI选手突发奇想要在提拉米苏里加老干妈时,这个警报器就会尖叫:“住手!你想毁了意大利百年甜点的尊严吗?!”

6. 偏好数据 → 吃货评审团

由1000名普通食客组成的评审团,他们可能给出最真实的反馈:“草莓蛋糕比香菜蛋糕好吃100倍!”——虽然不够专业,但代表了大众口味。

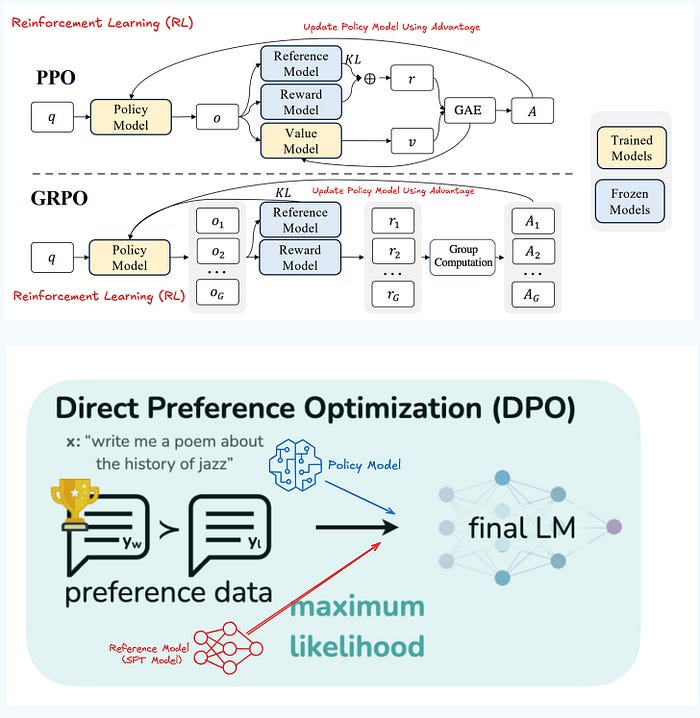

图1:PPO、GRPO和DPO的修罗场(来源1、来源2)

🏆 PPO篇:米其林星级特训营

🎭 剧情设定

• 主角:你的AI模型(每天烤500个戚风蛋糕的劳模)

• 教练:米其林三星主厨(参考模型)

• 考官:戴着单边眼镜的美食评论家(奖励模型)

• 预言家:会看面相的厨艺总监(价值函数)

🧑🍳 训练日常

- 初试阶段:AI按标准菜谱烤出第一个蛋糕

- 毒舌点评:“外皮火候差2秒!奶油打发过度!”

- 玄学预测:“不过这个选手三年后有望拿米其林星星”

- 谨慎调整:PPO会控制学习步伐:“今天只准调整0.1%的糖量!”

💣 潜在翻车现场

• 成本爆炸:请米其林评委每小时要花1000美元

• 效率低下:每个蛋糕要等评委细细品味半小时

• 评委偏见:万一遇到个"就爱焦苦味"的评委…

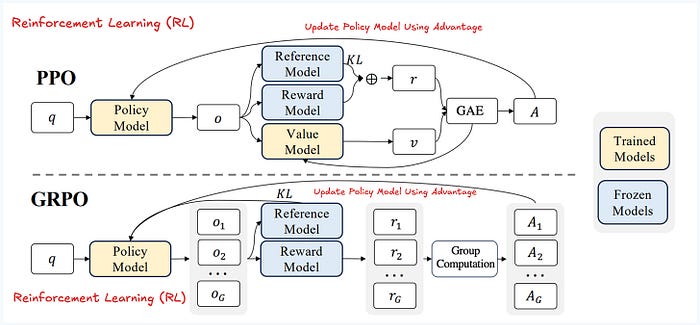

图2:PPO与GRPO的爱恨情仇(来源)

🎪 GRPO篇:烘焙社恐互助会

🌟 创新亮点

• 分组学习:把选手分成"巧克力狂热组"、"抹茶邪教组"等

• 省钱妙招:每组只抽样评审3个代表作

• 去掉玄学:开除那个整天神神叨叨的预言家

🤹 训练趣闻

• 组内偷师:“张师傅的蛋糕更蓬松?偷学!”

• 互相伤害:“李师傅的摆盘更好看?破坏!”

• 评委陷阱:如果评委说"越甜越好",最后全组都得糖尿病

🎯 适用场景

适合预算有限但又要比DPO稳定点的项目,就像学校里的学习小组——虽然比不上私教,但比自学强。

📺 DPO篇:全民烘焙大逃杀

🚀 核心优势

• 民主决策:直接让1000个吃货投票

• 极速迭代:观众说芒果好吃?明天就加三斤!

• 成本杀手:省掉了昂贵的米其林评委

🎭 真人秀剧本

- 第一轮:草莓蛋糕 vs 芒果蛋糕

- 观众投票:61%选择芒果

- 立即调整:把草莓配方扔进垃圾桶

- 第二轮:芒果蛋糕 vs 榴莲蛋糕…

- 灾难现场:遇到"臭豆腐蛋糕爱好者"群体

图3:DPO的民主暴政(来源)

🍻 终极对决:算法三巨头的华山论剑

📊 性能对比表

| 特性 | PPO | GRPO | DPO |

|---|---|---|---|

| 训练成本 | 💸💸💸(请米其林评委) | 💸💸(小组评审) | 💸(群众投票) |

| 稳定性 | ⭐⭐⭐⭐(稳步提升) | ⭐⭐⭐(可能内卷) | ⭐⭐(容易跑偏) |

| 适用场景 | 追求极致效果 | 平衡预算与质量 | 快速迭代产品 |

🧑🏫 AI厨神的忠告

- 土豪之选:PPO适合不差钱的大厂,就像请私教特训奥运选手

- 中庸之道:GRPO是性价比之选,像参加烘焙兴趣班

- 敏捷开发:DPO适合创业公司,虽然可能做出香菜月饼…

🤖 未来展望

也许明年会出现"HPO"(Hybrid Preference Optimization),结合米其林评委的专业性和大众评审的多样性。不过在那之前,各位AI厨师们,请继续在算法的厨房里挥洒汗水吧!记住——即使是失败的蛋糕,也能做成美味的提拉米苏!(这句话是不是很有哲理?快记下来当座右铭~)

AI厨神友情提示:

• 有钱有闲选PPO,想快糙猛选DPO,折中就试GRPO~

• 记住!没有免费的午餐,就像不存在完美的蛋糕配方(除非你穿越回2017年用原始GPT)