快速部署和体验内置开源 LLM 大模型

腾讯云 TI 平台已全面接入混元、Llama3、Llama2、Baichuan2、Chatglm、Qwen、Bloom 等 20+ 主流开源大模型。

本文档将为您介绍如何通过 TI 平台,一键部署开源大模型,快速试一试模型推理效果,助力用户快速选型适合您业务场景的开源大模型。

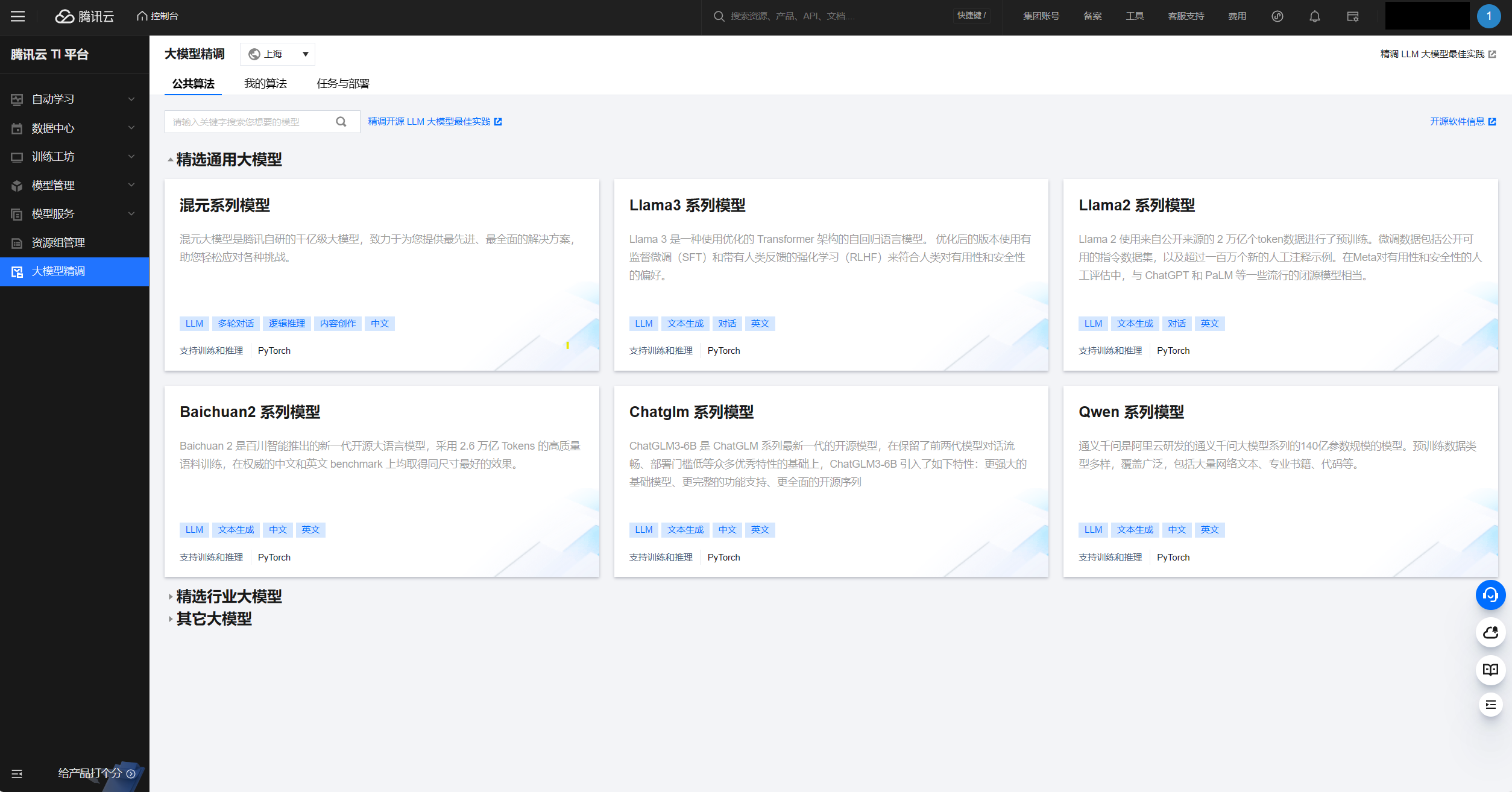

第一步:预览 TI 内置大模型清单

登录 腾讯云 TI 平台,在大模型精调首页,您可看到 TI 内置上架的开源大模型清单列表。

单击模型卡片,可进入每个模型页面查看详细介绍。

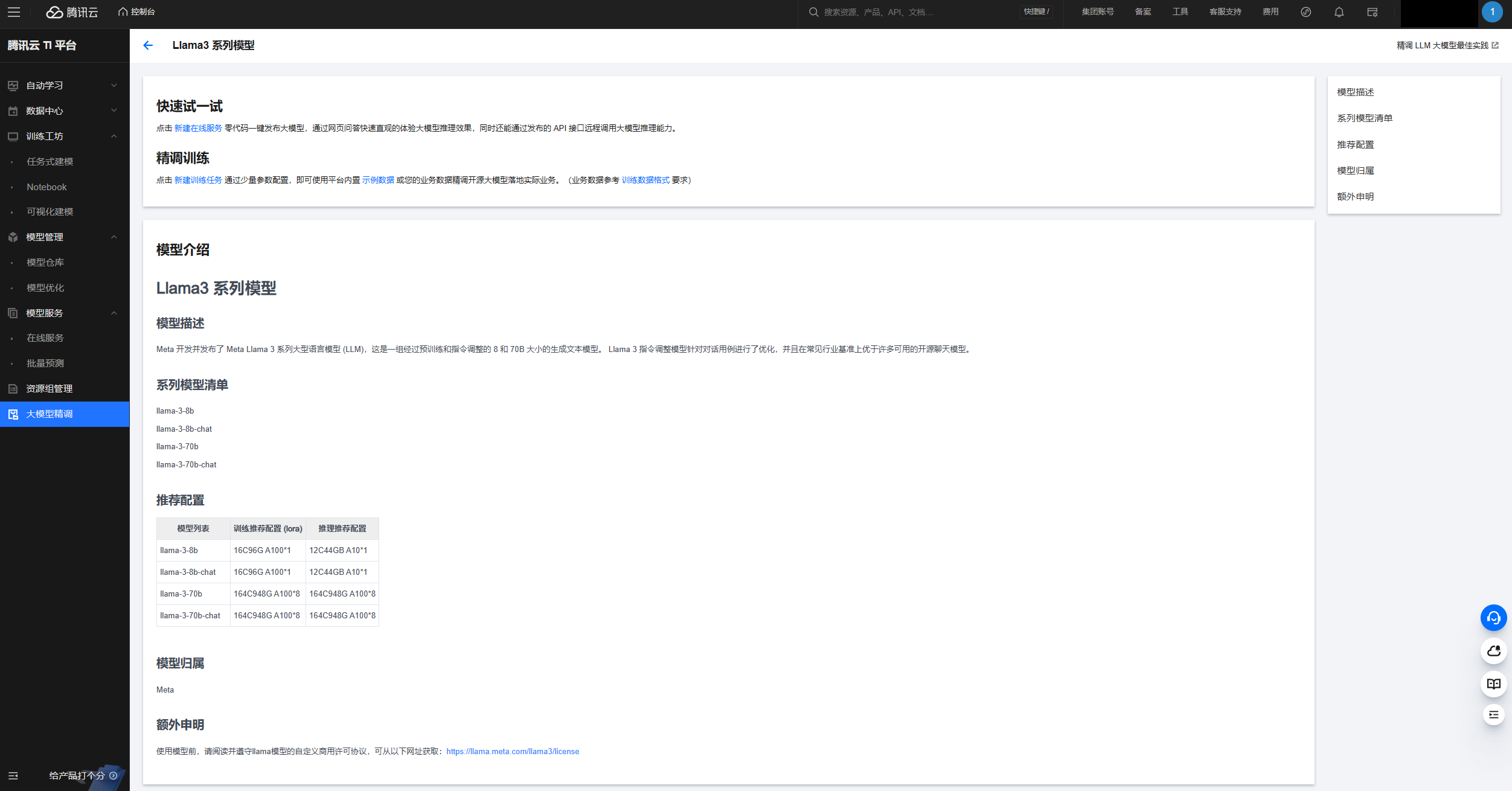

第二步:一键部署开源大模型

在模型详情页面,您可单击新建在线服务按钮,启动部署该大模型。本文档以部署“Llama3系列模型”中的llama_3_8b_chat模型为例。

单击后,平台会自动为您跳转到模型服务 > 在线服务的创建服务参数配置页面。

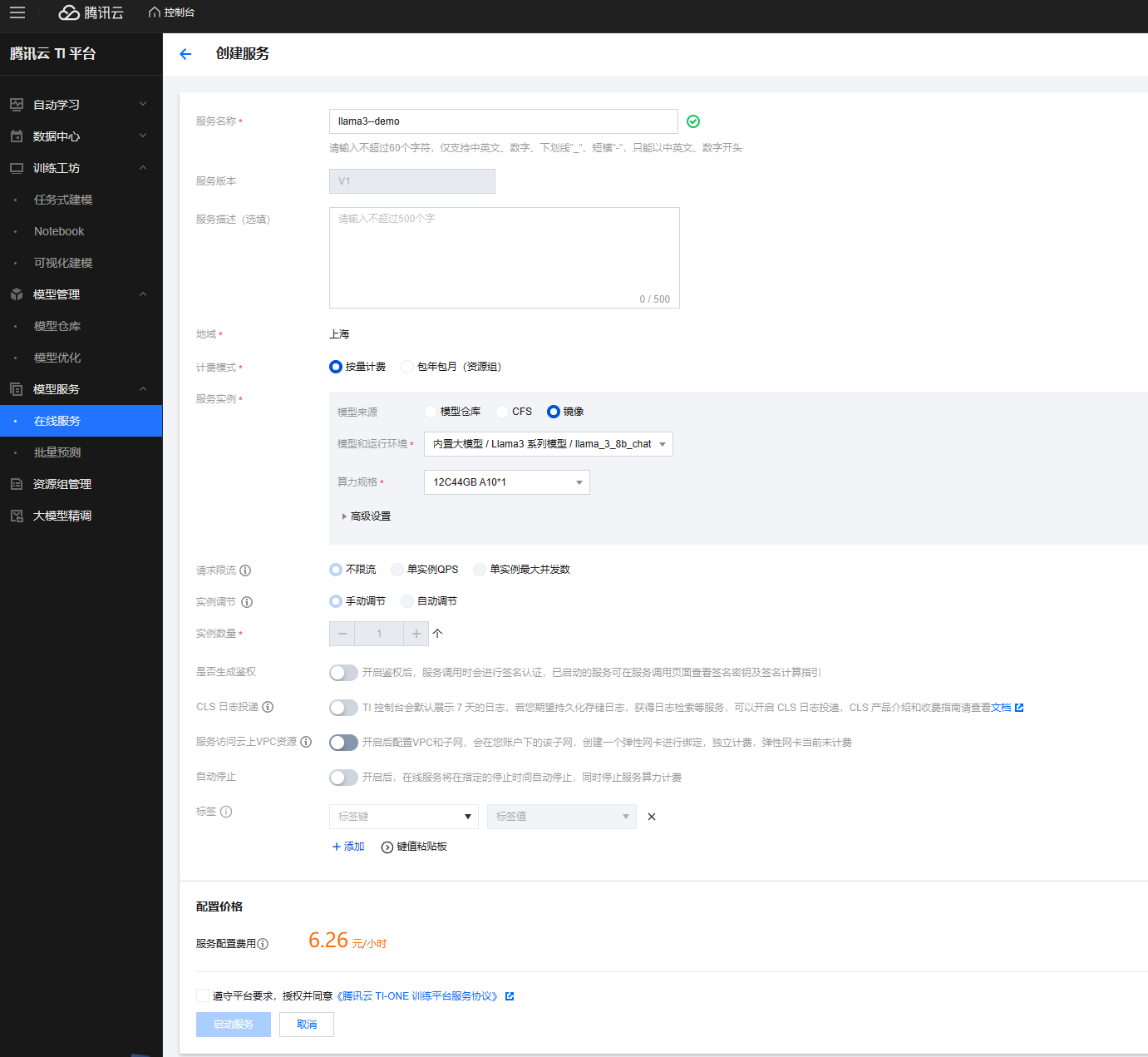

本页面重点参数配置如下:(其余参数都可使用默认值,不修改或按需修改)

服务名称:输入您的自定义服务名称。

计费模式:部署大模型推理服务支持“按量计费”和“包年包月”两种模式都可以。本示例采用“按量计费”。

服务实例

模型来源:选择 “镜像”类型。

模型和运行环境:系统已为您内置默认填充了“内置大模型/Llama3系列模型/llama_3_8b_chat”,也可选择其他内置模型,如Llama3系列下的llama_3_8b、llama_3_70b_chat、llama_3_70b等。

算力规格:本示例选择 12C44GB A10*1 的机器配置,此外还支持V100、A100等机型。

详情请参见 大模型推理所需资源指南。

单击同意开源大模型的相关法律协议后,即可单击启动服务按钮。

第三步:在线体验模型效果

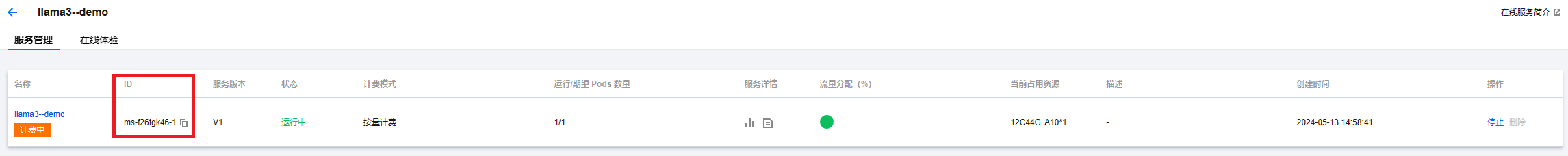

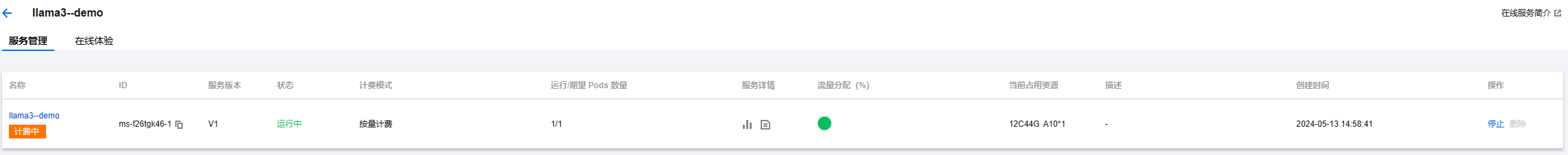

创建服务后,前端自动返回模型服务 > 在线服务列表页面,待大模型服务状态为“运行中”中后,表示服务已成功启动运行。

服务调用分为两种方式:

1. API 调用

您可以通过单击操作 > 调用API 按钮进入模型调用指导文档页面。文档中建议您通过API Explorer 配置调用代码。

其中,需填写到 API Explorer 的“Model”参数取值需参考在线服务>名称>服务管理页面展示的“ ID”参数。

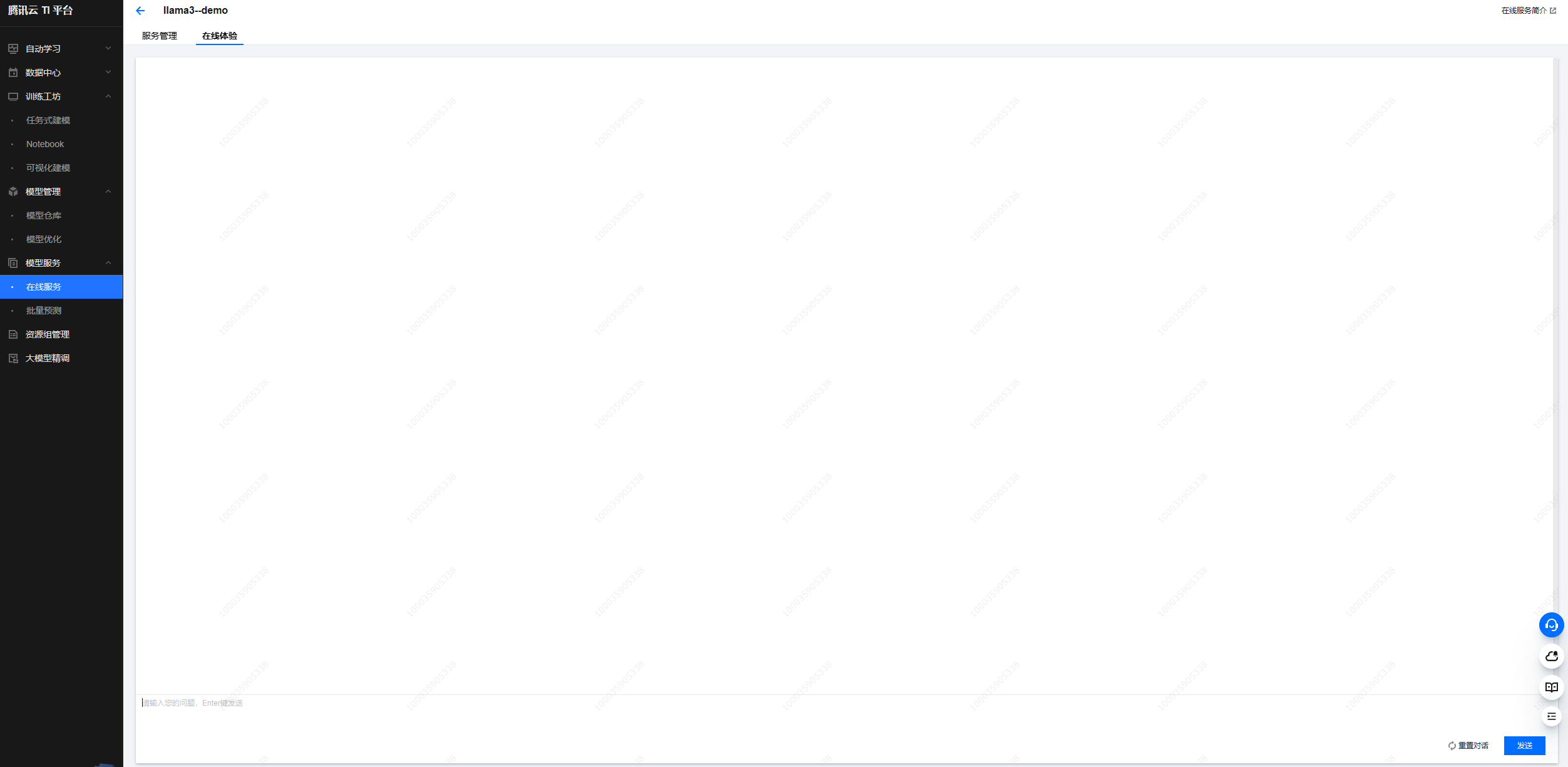

2. 在线体验

您可以通过单击操作 > 在线体验 按钮进入模型快速体验页面。您可通过前端页面问答形式测试精调后的模型效果。

第四步:管理模型服务,查看更多详情信息

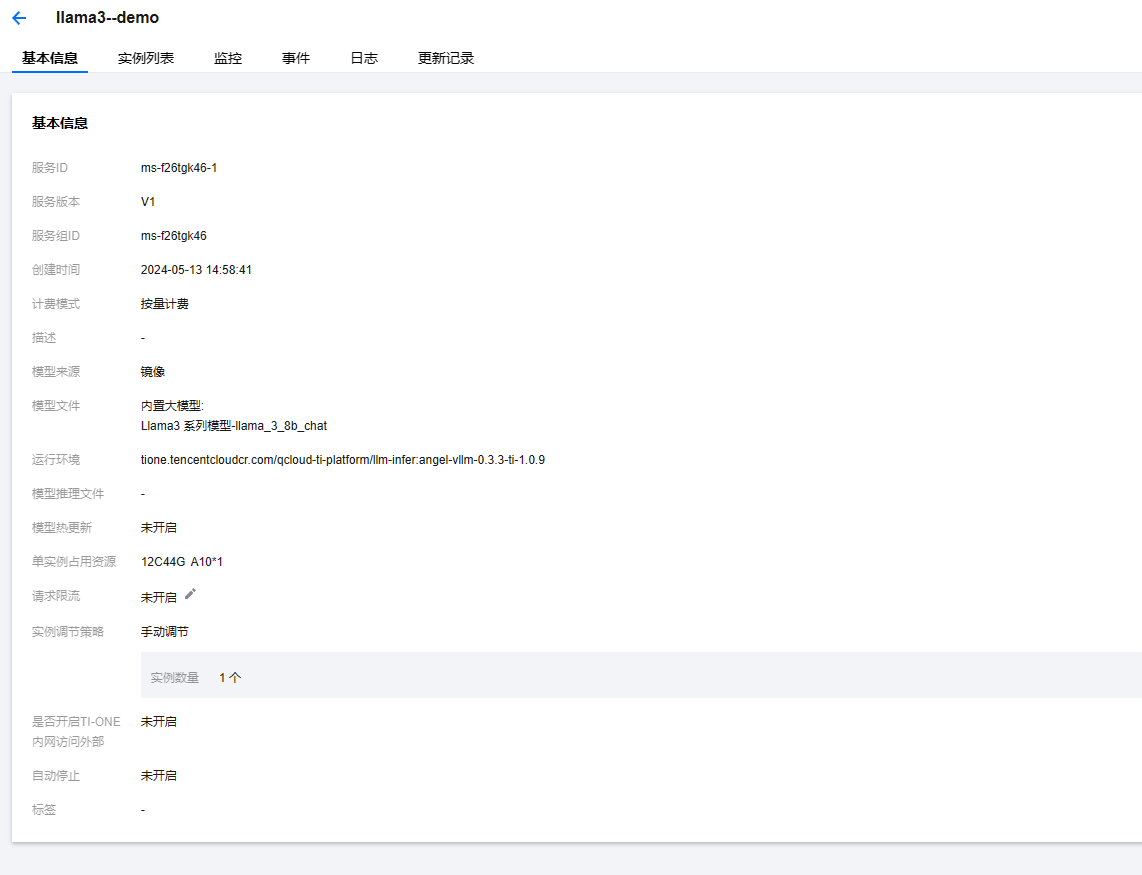

您还能通过模型服务 > 在线服务列表页面单击对应服务名称进入详细的服务管理页面。

您可通过服务管理页面的操作 > 停止/重启按钮控制服务状态,并通过单击“服务详情”的 icon 查看监控/日志;

也可以继续单击服务名称查看更详细的基本信息/实例列表/监控/事件/日志/更新记录等信息。