OpenCSG携手书生·浦语:InternLM2.5-20B-Chat 正式上线,共建AI未来新生态

OpenCSG共建AI未来新生态

OpenCSG传神社区 与 书生·浦语社区紧密合作,共同推动了国产AI大模型的创新与落地。作为这一合作的重要成果,书生·浦语系列最新版本书生·浦语2.5 模型正式上线OpenCSG社区,在OpenCSG传神社区上基于华为昇腾 910B 上实现 internlm2_5-20b-chat 模型的推理。开发者们无需自行开发和部署,可以直接通过平台轻松调用API服务到实际应用中。

来源:传神社区

AI大模型+国产芯片+开源社区

InternLM2.5-20B-Chat 正式上线OpenCSG

相比之前上线的 InternLM2.5-7B-Chat,InternLM2.5-20B-Chat 的综合性能更为强大,能够轻松应对更加复杂的应用场景。特别是在接入 MindSearch 多智能体框架 后,InternLM2.5-20B-Chat 能自主进行互联网搜索,并从上百个网页中高效整合信息。

作为书生·浦语社区在2024年推出的全新大语言模型在2024年推出的全新大语言模型,书生·浦语2.5 在性能和功能上实现了显著提升,具备以下三大核心优势:

-

推理能力显著增强

书生·浦语2.5的推理能力超越了国内外同规模的开源大模型,甚至在某些场景中表现优于 Llama3-70B 这样更大规模的模型。无论是文本生成、自然语言处理,还是复杂场景推理,它都能轻松应对各种复杂应用。 -

支持超长上下文处理

书生·浦语2.5具备处理 100万字 上下文的能力,能够应对超长文档和复杂文本任务。这一功能对如法律文档、金融报告等需要分析海量文本的场景尤为重要。 -

自主规划与工具调用能力

通过接入 MindSearch 多智能体框架,书生·浦语2.5能够自主进行互联网搜索,精准提取并整合来自上百个网页的信息,帮助用户在面对复杂问题时高效解决问题,提供全面的分析结果。这一能力大幅提升了模型的智能决策和信息整合效率。

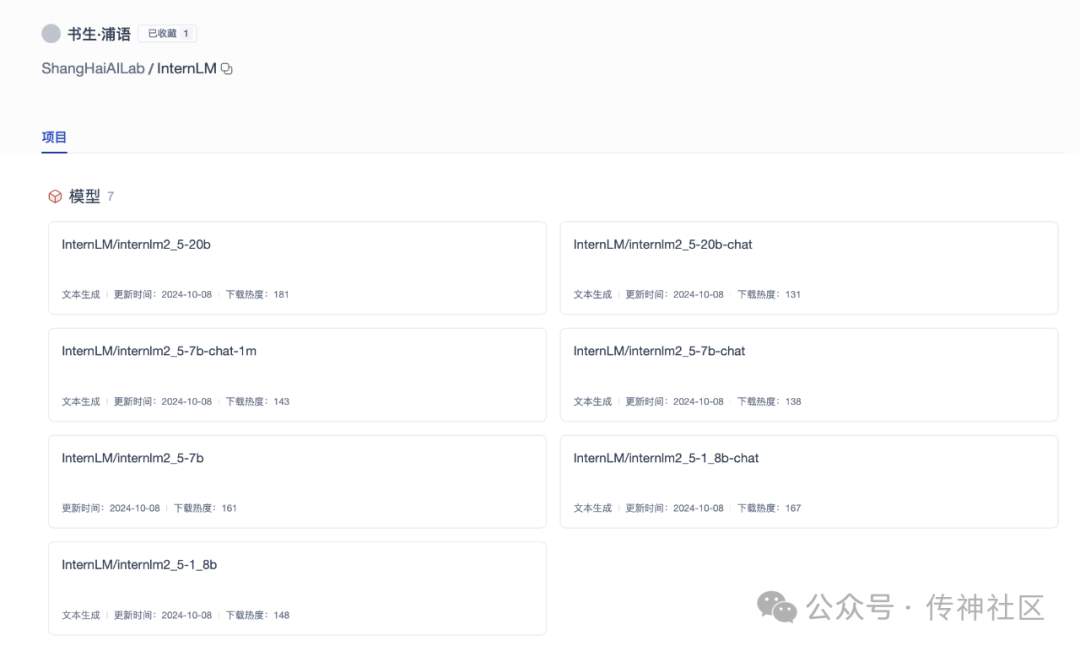

InternLM系列专区

-

InternLM2.5-1.8B:1.8B 模型可以有效地支持基础文本生成和处理任务,适合对性能要求不高的小规模应用和研究用途。尽管体积较小,但在核心功能上依旧能够提供稳定的输出和良好的响应速度,是一些移动端或边缘计算应用的理想选择。

-

InternLM2.5-7B:作为轻量级模型,7B 在性能和计算成本之间实现了平衡,适合研究和初步应用。尽管体积较小,但在多个基准测试中表现出色,为轻量应用提供了高性价比的解决方案。

-

InternLM2.5-20B:20B 模型拥有更高的参数量和处理能力,能够支持复杂且高计算需求的应用场景。它在推理和生成任务中表现优异,推荐用于要求较高的工业应用和企业级解决方案。

-

InternLM2.5 基座模型:该模型经过大规模预训练,适用于多种应用场景。基座模型具有较强的通用性和适用性,是用户在大部分任务中优选的选择。

-

InternLM2.5-Chat:该对话模型基于 InternLM2.5 进行监督微调和 online RLHF 优化,具备优异的指令遵循、共情对话和调用工具的能力。它专为对话场景设计,是用户直接应用于互动场景的理想选择。

-

InternLM2.5-Chat-1M:在 Chat 版本基础上扩展至支持一百万字的超长上下文,使得长文本上下文需求的任务更加流畅。该模型保持了 Chat 版本的优异性能,适合需要处理超长文本的应用。

InternLM2.5各参数模型现已在专区上线,可适用于多种应用场景。具体参数包括从1.8B到20B的模型,分别支持文本生成和对话模式。OpenCSG社区还特别提供了InternLM2.5-20B-Chat的在线推理体验,用户可以通过一键操作直接体验该模型的对话功能~

https://opencsg.com/collections/43/

在线体验传送门:(文末点击阅读原文可直达)

一起来直观感受下 InternLM2.5-20B-Chat 在 OpenCSG社区上的推理效果~

上海电信强力支持

随着生成式人工智能的快速发展,AI算力的需求日益增长。据预测,全球AI加速计算市场将在未来几年达到数千亿美元的规模。中国电信作为国内领先的通信和科技企业,在推动国产算力落地方面发挥了重要作用,特别是在液冷智算中心的建设和运营上已取得显著进展。上海电信在临港建设的智算中心拥有昇腾910B算力集群,具备支持万亿参数规模大模型训练的能力,极大地提升了训练效率。

值得一提的是,华为昇腾作为国产AI算力的代表,凭借软硬件的全面布局,成为了大模型训练领域的关键力量。昇腾芯片基于达芬奇架构,具备强大的运算性能,特别是昇腾910B的推出,其性能接近英伟达A100,成为了AI加速芯片市场中的重要竞争者。这一国产算力突破了以往大模型在英伟达GPU上运行的壁垒,华为通过适配训练框架和大模型,使得国产芯片在AI推理和训练中的表现更加高效。

通过与中国电信和华为昇腾的战略合作,OpenCSG传神社区和书生·浦语社区得以借助昇腾910B的强大算力,不仅加速了大模型的训练部署,还打通了从数据集获取到模型训练的全链路流程。特别是在上海电信的支持下,OpenCSG传神社区的模型训练可以通过“双万兆接入暨一跳入算服务”,一跳直达临港智算中心,极大降低了网络接入时延,提高了大模型训练的效率。

这次合作将推动AI算力基础设施的进一步完善,为大规模AI应用提供了坚实的支持,同时也促进了国产算力在全球AI市场的竞争力。

关于昇腾910B

昇腾910是一款专为数据中心设计的高性能AI处理器,主要用于加速机器学习和深度学习任务。昇腾910B主要采用的是华为自主研发的Da Vinci架构,7纳米制程工艺、具有高算力、低功耗的特点。

关于OpenCSG

开放传神(OpenCSG)成立于2023年,是一家致力于大模型生态社区建设,汇集人工智能行业上下游企业供应链共同为大模型在垂直行业的应用提供解决方案和工具平台的公司

关于InternLM2.5

在 2024 年 7 月 4 日的 WAIC 科学前沿主论坛上,上海人工智能实验室推出了书生·浦语系列模型的全新版本——InternLM2.5。相较于上一代,InternLM2.5 全面增强了在复杂场景下的推理能力,支持 1M 超长上下文,能自主进行互联网搜索并从上百个网页中完成信息整合。

书生·浦语系列大模型主页:

https://internlm.intern-ai.org.cn

Hugging Face 主页:

https://huggingface.co/internlm

OpenCSG主页:

https://opencsg.com/organizations/ShangHaiAILab

开源链接:

https://github.com/InternLM/InternLM

欢迎加入传神社区

•贡献代码,与我们一同共建更好的OpenCSG

•Github主页

欢迎🌟:https://github.com/OpenCSGs

•Huggingface主页

欢迎下载:https://huggingface.co/opencsg

•加入我们的用户交流群,分享经验

扫描上方二维码添加传神小助手

“ 关于OpenCSG

开放传神(OpenCSG)成立于2023年,是一家致力于大模型生态社区建设,汇集人工智能行业上下游企业链共同为大模型在垂直行业的应用提供解决方案和工具平台的公司。

关注OpenCSG

加入传神社区