阿里云大模型,这次云栖大会又“卷”出了新高度!

2024 云栖大会上,阿里云又对大模型“出手”了。

自2022年,ChatGPT横空出世后,大模型一路狂“卷”,速度超过了以往任何一项技术的发展进程。

阿里云是国内最早一批对大模型技术进行布局的企业,也是业内出名的“卷王”。2019年,阿里云就启动了大模型研发。2023年4月,阿里云发布了自研大模型「通义千问」。2023年云栖大会,阿里云正式发布千亿级参数大模型通义千问2.0。

凭借着阿里云上下的不停的自“卷”,通义千问大模型无时无刻都在向着更高的技术指标进级。2024年5月,通义千问2.5在权威基准OpenCompass上的得分追平GPT-4 Turbo,成为国产大模型取得的最出色的成绩。今年6月,通义千问开源Qwen2,迅速登顶Huggingface的全球开源模型排行榜。在Huggingface上,Qwen的原生和衍生模型接近5万个,排名全球第二。

阿里CEO 吴泳铭

阿里CEO吴泳铭表示:“过去22个月,AI发展的速度超过任何历史时期,但我们现在依然还处于AGI变革的早期阶段。要实现真正的AGI,下一代模型需要具备更大规模、更通用、更泛化的知识体系,同时也将具备更复杂更多层次的逻辑推理能力。”

为此,仅隔4个月后,阿里云在云栖大会上又发布了通义千问大模型多项最新进展,在技术、商业、生态三方面,都取得了突破性进展。那么阿里云是如何在大模型领域取得如此出色的成绩的呢?核心还是自“卷”,阿里云不断的“卷”自己的基础模型,“卷”自己的功能应用,“卷”开源开放,将“卷”发挥到了极致,才带来阿里云在大模型的不断突破。下面我们来看下阿里云在这三方面是如何“卷”的:

▉ “卷”基础模型,夯实高效应用基础

随着“千模大战”愈战愈酣,市场上涌出了大量专注于大模型应用开发的创业公司,如Adept、Stability.ai、Runway、BettrData、Tinybird、UnSkript等等。

同时,像OpenAI、Anthropic这样的大模型头部领军企业以及如谷歌、微软等科技巨头也在致力于利用开源模型或自主研发的基础模型,开发出各种应用场景的解决方案。

于是,大模型市场开始出现一种论调:大模型不要“卷”基础模型,要“卷”场景应用。乍一看这种论调似乎并没有问题,但他们往往忽略一个根本问题,万丈高楼平地起,一砖一瓦皆根基,基础模型是大模型的根基,盲目跟风去“卷”场景应用,往往让自己的根基没有筑牢。

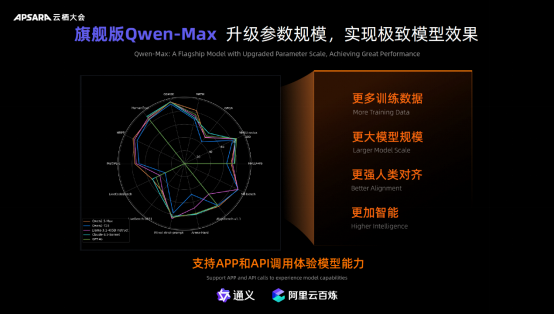

阿里云在推动大模型场景应用落地的同时,依然积极“卷”基础模型。在此次大会上,阿里云在基础模型上持续丢出大招。旗舰版模型Qwen-Max(阿里版GPT-4o)、Qwen2.5、Qwen2-VL、Qwen2.5-Audio、Qwen2.5-Math等连环引燃现场,让通义家族彻底在云栖上出圈了!

例如,此次发布会阿里云对旗舰版Qwen-Max参数规模进行了进一步升级,实现极致模型效果,训练数据更多,模型更大,从而让模型更智能,让“通义App”以及调用API的应用能够精准高效地服务金融、法律、科研、医疗、教育等领域专业人士。

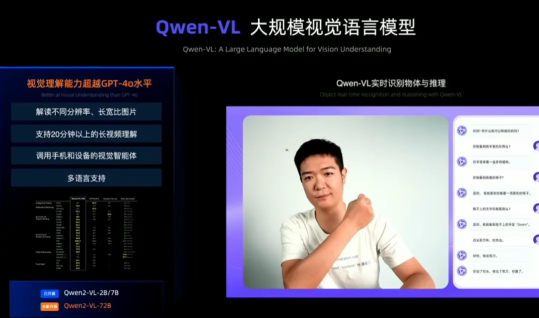

同时,阿里云发布的Qwen2-VL大规模视觉语言模型,在之前的图片理解上,新增了对视频的理解和推理能力,甚至超越了GPT-4o的水平,支持长达20分钟以上长视频理解,可以调用手机和设备的视觉智能体,支持多种语言。

另外,Qwen2.5-Audio大规模音频语言模型则融合了语音识别和语音理解,无须通过ASR模块,就能快速识别音乐、情绪、环境声音等信息,实现了端到端的大模型,大大降低延迟。

值得注意的是,阿里云在云栖大会还推出了专用于解决数学问题的Qwen2.5-Math。根据研发团队的评测,数学力超越所有开源模型及GPT-40数学能力。

不仅如此,此次大会上,通义万相Wanx还发布了文生视频能力,具备强大的画面视觉动态生成能力,擅长概念理解与组合生成,给用户提供多种艺术风格,带来影视级质感的画面,并且支持多语言和适配多种规格比例的视频。据了解,此次云栖大会飞天音乐节现场视频就是借助通义万相生成。

▉ “卷”功能升级 加速大模型应用落地

目前,通义千问官网和App接入的都是通义千问Max升级后的版本。比上一代又有了巨大提升。特别是在中文语境下,新版本的文本理解、文本生成、知识问答及生活常识等能力得到了显著增强,持续领先业界。

今年,通义千问大模型的升级也让应用“全家桶”的功能带来了全面的升级:

现在,智能编码助手“通义灵码”进一步增强,只需给出问题,基于阿里云通义代码大模型打造的智能编码就会帮助用户自动编写代码。至今,“通义灵码”插件下载量超过500万,为开发者编写超过10亿行代码,企业开发一个大模型应用,最快也只需几分钟就能搞定。

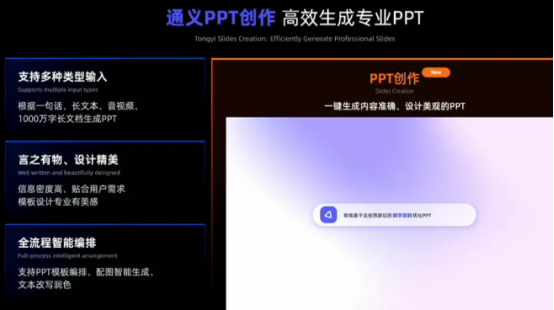

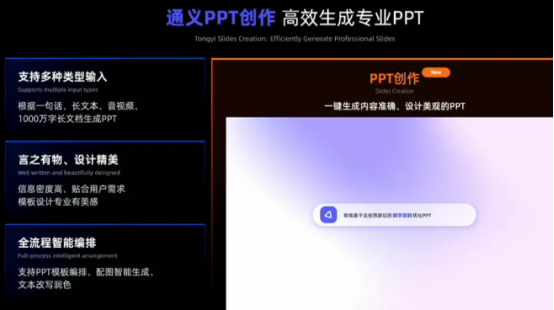

另外,通义还上线了“PPT创作”功能,能够一键生成内容准确、设计美观的PPT。用户只需要根据一句话、长文本、音视频、长文档就能智能生成PPT。而且提供了全流程智能编排的能力,可在线实时调整PPT模板编排、PPT配图智能生成、PPT文本智能改写等。

同时,通义AI翻译助手可以提供实时语音翻译,提供准确、流畅、快捷的对话体验。而且支持多语言翻译,语种持续拓展。

通义实时记录&阅读助手也进一步升级,在原有基础上增强了模型能力。不仅可以很好地区分发言人,根据不同发言人整理核心观点,而且,用户可以边听边选中文段,自己划重点。

另外,为了更好的服务客户,百炼大模型平台从模型开发,到应用开发,再到算力底座全面升级,更加易用、更加开放。同时,百炼平台引入了更多模型,并率先兼容LlamaIndex等开源框架,赋能企业自由替换能力组件从而适配自身系统。

针对当下企业最关注的RAG链路,百炼平台提供了灵活开放的企业级检索增强服务,5到10行代码即可搭建RAG应用,让大模型拥有“最强外挂”,让搭建企业级RAG应用像搭乐高一样灵活。

当然,阿里云也在与很多企业客户合作开发和推动大模的应用落地,作为“All in AI”的车企,小鹏汽车基于自主研发的“全域大语言模型”X-GPT及通义千问全面升级了车载助理。小鹏汽车在官方App中已接入通义万相,在研发场景中,通义灵码的代码评审采用率高达50%。

▉ “卷”开源开放:降低大模型使用门槛

大模型是本轮AI浪潮的核心技术,千行百业都想借助大模型实现生产和服务方式的变革,但大模型使用的高门槛把大部分人挡在了技术浪潮之外。

阿里云通过AI开源社区“魔搭”来开源,同时降低模型推理的成本,来进一步降低开发者使用模型、使用AI的成本。

截止到2024年8月份底,阿里云开源模型下载量超4000万,是下载量最高的中国大模型。在Huggingface上,Qwen2的原生和衍生模型超过五万个,排名全球第二,是仅次于Llama的世界级模型群。通义是Qwen系列是最强、最卷的开源大模型,如今在HF上广受好评,获得大量开发者点赞。通义不仅坚持开源开放,还要将开源开放生态做到极致,完成走向开发者/企业的最后一步。

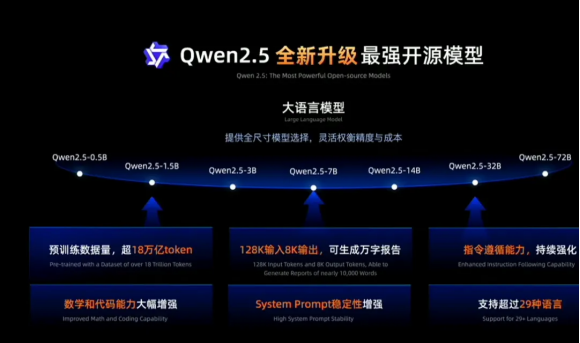

同时,新发布的Qwen2.5模型能够支持高达128K的上下文长度,可生成最多8K内容,支持超29种语言,这意味着能帮用户胜任万字文章撰写。不仅如此,基于18T token数据预训练,相比Qwen2,Qwen2.5整体性能提升18%以上,拥有更多的知识、更强的编程和数学能力。

而且,Qwen2.5还提供了0.5B、1.5B、2B、14B、32B、72B等全尺寸开源,卡紧每一个生态位,它们的型号设定充分考虑了下游应用的不同场景需求,比如,0.5适合极致低功耗场景,比如耳机、鼠标等;3B是适配手机等端侧设备的黄金尺寸;32B是最受开发者期待的“性价比之王”,可在性能和功耗之间获得最佳平衡;72B是开源旗舰版本,适配企业级和科研级的应用场景。

能听、能看、能做数学题、能写代码的各类SOTA模型都开源了。为了便于开发者部署使用,每个模型都开出了Base、Instruct等多种版本。

在竞争激烈的大模型领域,每一小步提升,都意味着更大的竞争优势,所以大厂们无时不刻都在向着更高的技术指标进级。在这种情况下,阿里通义千问只用了短短4个多月的时间,就进行了大量的升级,这是极其难能可贵的。如果阿里可以一直保持如此迅猛的发展态势,完全有机会冲击国产AI大模型之巅,成为新科技时代的No.1。

▉ AI重构阿里坚不可摧的“护城河”

目前,AI大模型已经不是营销初期,而是实打实的技术创新。没有核心优势的企业,都会随着技术的快速迭代,慢慢湮没在滚滚历史洪流中。生成式AI对数字世界和物理世界的重构,将带来计算架构的根本性变化。

过去几十年,CPU主导的计算体系,正在加速向GPU主导的AI计算体系转移。未来几乎所有的软硬件都会具备推理能力,它们的计算内核将变成GPU AI算力为主、CPU传统计算为辅的计算模式。

和“千团大战”的结局类似,只有极少数大模型公司能够“笑到最后”。作为最早转型“硬科技”的互联网巨头之一,阿里经过十余年的技术积淀,已初步具备穿越周期的条件。

在新增算力市场上,超过50%的新需求由AI驱动产生,AI算力需求已经占据主流地位。这一趋势还会持续扩大。过去一年,阿里云投资新建了大量的AI算力,但还是远远不能满足客户的旺盛需求。

如今,所有行业,都需要性能更强、规模更大、更适应AI需求的基础设施。

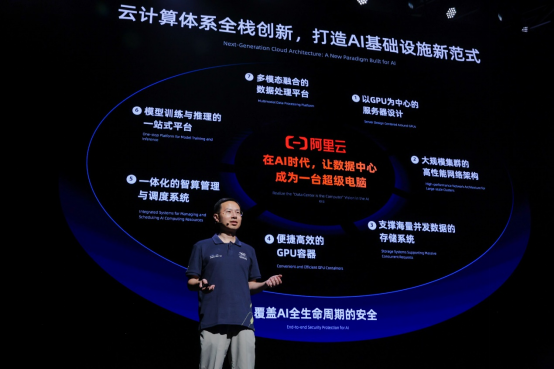

阿里云正在以前所未有的强度投入AI技术研发和基础设施建设。如今阿里云单网络集群已拓展至十万卡级别,正在从服务器、网络、存储、容器、管理、安全等方方面面,重新打造面向未来的AI先进基础设施。

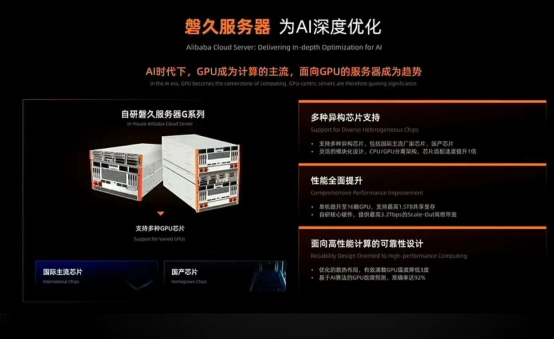

在此次发布会上,阿里云推出为AI 深度优化的磐久G系列服务器,如今GPU成为计算的主流,面向GPU的服务器成为趋势,磐久服务器能够支持多种异构芯片,同时单机提升至16颗GPU,支持最高1.5TB共享显存。通过自研核心硬件,提供最高3.2Tbps的Scale-0ut网络。而且面向高性能计算的可靠性设计。

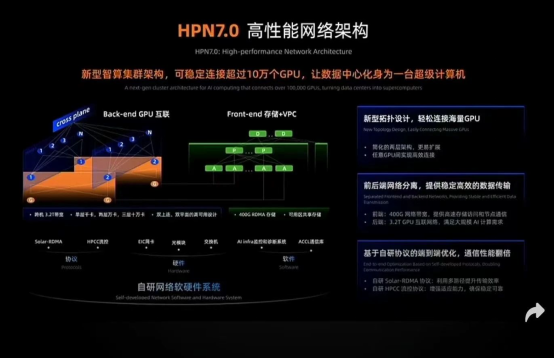

在网络方面,大模型对AI基础设施提出了更高要求,HPN7.0架构为AI时代超大规模、超高稳定性的网络需求而研发,可稳定连接超过10万个GPU,让数据中心化身为一台超级计算机。

同时,阿里云面向AI推出全新升级的存储系统CPFS智算版,单文件系统容量提升500% 达到6PB级别,在大规模训练场景中,可支持更大的数据量和更高性能。同时,CPFS全新升级系统智能引擎,冷热数据流动带宽提升20倍,可大幅降低存储成本,更好支撑大模型训练及推理。

为了解决今天在容器方面的挑战,阿里云升级了容器计算服务ACS。通过动态细粒度热调整,CPU资源自适应原地热变配,业务不断连。同时算力交付模式升级为 Serverless形态,ACS支撑的负载类型也更加丰富,大幅降低了企业使用容器、K8s的代价和成本,打造用云新范式。

而且,为了保证大模型训练的稳定互联和高效并行计算,阿里云全新升级了人工智能平台PAI。在大模型训练任务中,优化大模型服务,提高效率和优化成本,性能更强,成本更低借此,阿里云构筑一条AI时代坚不可摧的“护城河”,为企业客户提供强有力的AI大模型和基础设施支持。

未来,阿里云将不断壮大自身产业生态,并发展成为整个行业的赋能者。截至2024年9月,阿里云已与70+国家、87个可用区的30万+客户进行深度合作,这个成绩,无疑再一次跑赢了绝大部分竞争者。

总之,凭借独有的技术优势和生态布局,阿里通义千问是最有机会成为行业的领头羊的大模型。

写在最后:

作为最早转型“硬科技”的互联网巨头之一,阿里凭借十余年积淀下来的技术优势,如今已经在AI大模型领域构筑了一条坚不可摧的护城河。未来,随着阿里云生态的不断壮大,阿里通义千问将成为最有机会登顶行业之巅的大模型。期待阿里这个庞然大物,在AI这一轮产业变革中成功完成转型、蜕变!

END