被秀到了!注意力+时空特征融合,秒锁1区!快码住学思路

注意力机制+时空特征融合,是一个创新拉满的高分思路!

近来更是取得了新突破,模型STA-DRN在面部视频识别任务中,误差直降43.34%;模型MFF-EINV2在定位任务中,参数狂减68.5%……不仅如此,其在CVPR24、AAAI24等顶会上也都有不少成果。

可见其热度!这主要得益于,该结合能显著提升模型对复杂数据的处理能力,为需要同时考虑时间和空间维度的任务提供了新思路。像是遥感、交通预测、金融、医学等。时空特征融合能整合来自不同时间和空间尺度的信息,为模型提供更丰富的特征输入。而注意力机制则能动态调整不同特征的权重,使模型更加关注任务相关的信息。

此外,想发论文的伙伴,可以多关注时空特征融合策略、模型鲁棒性和泛化性提升等。为让大家能获得更多idea启发,我给大家准备了15种前沿思路和源码!

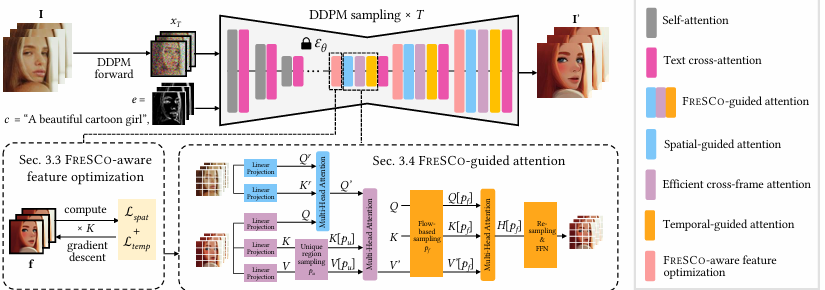

FRESCO: Spatial-Temporal Correspondence for Zero-Shot Video Translatio

内容:论文介绍了FRESCO,这是一个用于零样本视频翻译的空间-时间对应框架。它通过结合帧内和帧间对应关系,提供了一种鲁棒的空间-时间约束,以确保在视频帧之间转换时保持语义相似内容的一致性。这种方法显著提高了视频翻译的视觉连贯性,并在多个实验中展示了其在生成高质量、连贯视频方面的有效性。

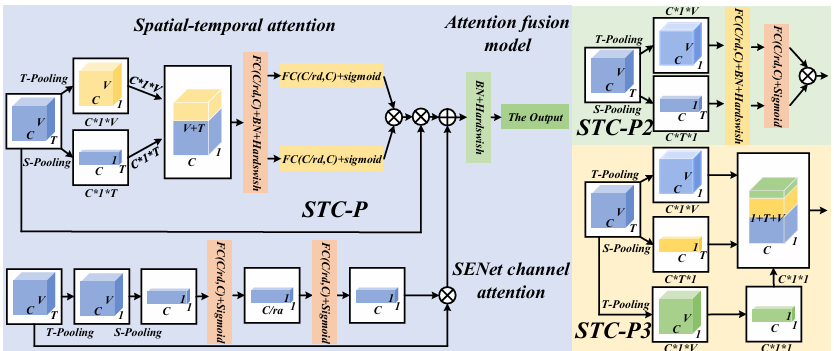

Behavioral Recognition of Skeletal Data Based on Targeted Dual Fusion Strategy

内容:文章介绍了一种基于目标导向的双融合策略的行为识别方法,通过提出前-后双融合图卷积网络(FRF-GCN)和空间-时间-通道并行注意力(STC-P)机制,旨在从骨骼数据中提取互补特征,提高识别准确性,同时降低模型复杂性和参数数量。该方法在NTU RGB+D、NTU RGB+D 120和Kinetics-Skeleton 400数据集上显示出与当前最先进方法相比具有显著的竞争力。

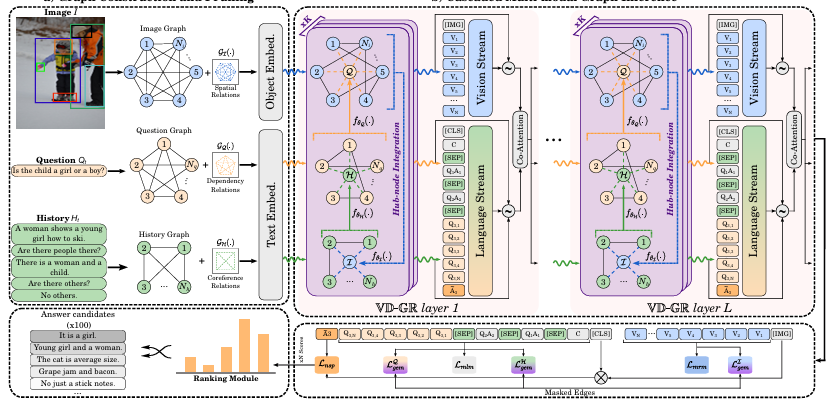

VD-GR: Boosting Visual Dialog with Cascaded Spatial-Temporal Multi-Modal GRaphs

内容:这篇论文介绍了VD-GR,这是一个结合了预训练语言模型(如BERT)和图神经网络(GNNs)的新型视觉对话模型。VD-GR通过在多模态GNN和BERT层之间交替,利用GNNs处理图像、问题和对话历史的局部结构,然后通过BERT层进行全局注意力机制,并通过引入中心节点(hub-nodes)在不同模态图之间进行信息的级联传播,从而增强模型对多模态上下文的理解。

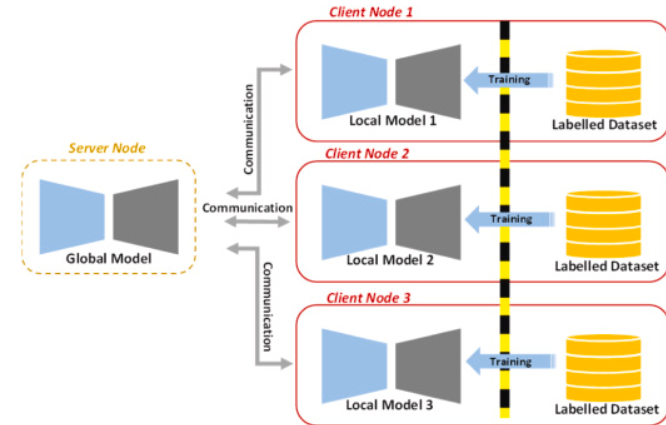

Self-supervised spatial–temporal transformer fusion based federated framework for 4D cardiovascular image segmentation

内容:文章介绍了一种基于联邦学习的自监督空间-时间变换器融合(SSFL)框架,用于4D心血管图像分割。该框架利用空间-时间Swin变换器从3D SAX多个阶段(心脏完整周期)提取特征,并通过一个包含25个编码器的高效自监督对比框架来建模时间特征。然后将空间和时间特征融合并传递给解码器,以使用电影MRI图像进行心脏分割。

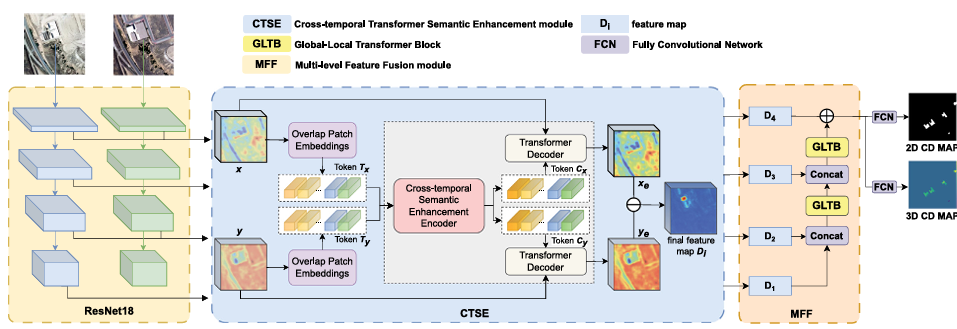

Cross-temporal andspatial information fusion for multi-task building change detection using multi-temporal optical imagery

内容:文章介绍了一种名为Cross-temporal and Spatial Context Learning Network (CSCLNet)的多任务建筑变化检测网络,它能够同时捕捉2D和3D变化,以提高从双时相光学图像中检测建筑变化的准确性。CSCLNet利用卷积神经网络提取多层语义特征,并通过两个模块——Cross-temporal Transformer Semantic Enhancement (CTSE)和Multi-layer Feature Fusion (MFF)——来优化特征表示,分别增强时间信息和融合多层特征以关注全局和局部空间上下文。

码字不易,欢迎大家点赞评论收藏!

关注下方《AI科研技术派》

回复【ASSF】获取完整论文

👇